È possibile confrontare la RAM con la memoria a breve termine di una persona e un disco rigido con la memoria a lungo termine. La memoria a breve termine si concentra sul lavoro a portata di mano, ma può solo tener conto di tanti fatti in una sola volta. Se la memoria a breve termine si riempie, il tuo cervello è talvolta in grado di aggiornarla da fatti memorizzati in memoria a lungo termine. Un computer funziona anche in questo modo. Se la RAM si riempie, il processore deve continuamente andare sul disco rigido per sovrapporre i vecchi dati in RAM con nuovi, rallentando l’operazione del computer. A differenza di un disco rigido, che può essere riempito completamente di dati ed è in grado di accettarne di più, la RAM non esaurisce mai la memoria.

DRAM vs. SRAM

La RAM viene in due forme primarie:

- Memoria ad accesso casuale dinamico. La DRAM è ciò che costituisce la tipica RAM del dispositivo di calcolo e, come detto sopra, richiede costante potenza per mantenere i dati memorizzati.

- Memoria ad accesso casuale statico. SRAM non necessita di potenza costante per mantenere i dati, ma il modo in cui vengono prodotti i chip di memoria significa che sono molto più grandi e migliaia di volte più costosi di una quantità equivalente di DRAM. Tuttavia, SRAM è notevolmente più veloce della DRAM. Le differenze di prezzo e di velocità significano che SRAM viene utilizzato principalmente in piccole quantità come memoria di cache in un processore di un dispositivo. E’ facila trovarla nei migliori notebook (vedi migliornotebook.net e capirai il motivo) in quanto presenta delle dimensioni notevolmente inferiori rispetto alla DRAM.

Cenni storici

La RAM viene chiamata memoria ad accesso casuale perché è possibile accedere direttamente a qualsiasi posizione di archiviazione, nota anche come indirizzo di memoria. In origine, il termine ha distinto la memoria regolare normale dalla memoria non in linea, di solito su nastro magnetico in cui una serie di dati poteva essere raggiunta solo partendo dall’inizio del nastro e trovando un indirizzo in sequenza. La RAM è organizzata e controllata in modo tale che i dati siano memorizzati e recuperati direttamente in luoghi specifici. Si noti che altre forme di archiviazione, come il disco rigido e il CD-ROM, sono anche accessibili direttamente o casualmente, ma il termine accesso casuale non viene applicato a queste forme di archiviazione.

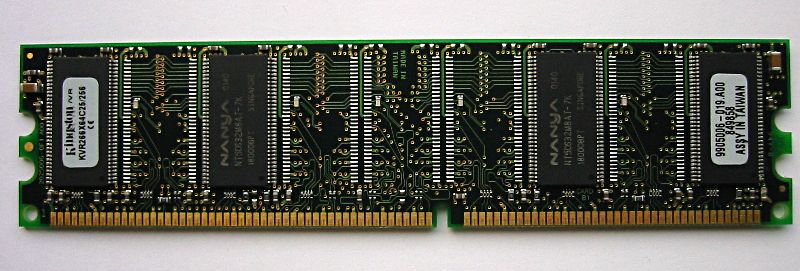

La RAM inizialmente veniva usata in asincrono, ovvero aveva una velocità di clock differente rispetto al processore. Questo è stato un problema in quanto i processori sono diventati più potenti e la RAM non era in grado di tenere il passo con le richieste sempre più pesanti di dati dal processore. Nei primi anni ’90 le velocità di clock sono state sincronizzate con l’introduzione della memoria dinamica di accesso casuale sincrono. SDRAM ha raggiunto rapidamente il suo limite, poiché trasferiva i dati in una singola velocità di trasmissione. Intorno all’anno 2000 è stata sviluppata una doppia velocità di trasmissione di dati (DDR RAM). Questo ha trasferito i dati due volte in un singolo ciclo di clock – all’inizio e alla fine. L’introduzione della RAM DDR sembra anche cambiare la definizione di SDRAM, infatti da molte fonti viene definita come RAM singola.

La DDR RAM si è evoluta tre volte, attraverso DDR2, DDR3 e DDR4. Ogni iterazione ha migliorato le velocità di trasmissione dei dati e ridotto l’utilizzo di potenza. Tuttavia, ogni versione non è compatibile con quelle precedenti, poiché i dati vengono gestiti in gruppi più grandi per ogni serie.